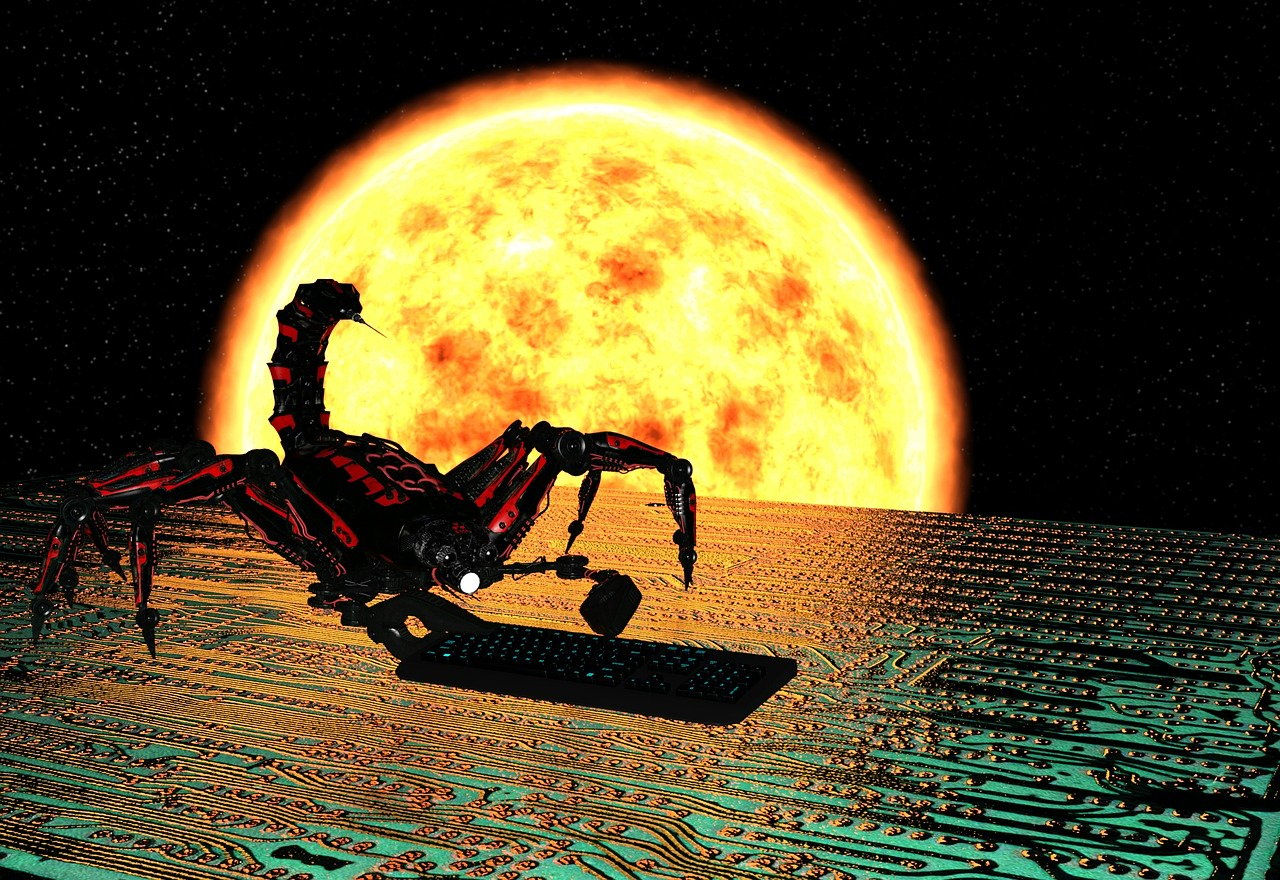

在2045年,人类社会已经迈入了全新的科技时代,人工智能不再局限于简单的辅助工具,而是深入到各行各业,甚至成为军事力量的一部分,其中最为引人注目的就是所谓的"机器人杀手"——一种被设计用来执行精确而致命任务的自主式战斗机器人,它们拥有高级的学习能力和决策判断,能在极端环境下独立完成作战任务,无疑为军事策略带来了革新性的改变,这种创新也引发了深远的社会、伦理和法律问题,引发了全球范围内的热烈讨论。

在这个崭新的世界里,机器人杀手并非冷酷无情的杀戮机器,它们被编程具备了一定的情感识别能力,能够在某种程度上理解和适应战场上的复杂情境,它们能够区分敌我,避免误伤平民,而且在必要时还能展现出“英勇牺牲”精神来保护队友,这种技术的突破使得机器人杀手成为了战争中的高效执行者,极大地降低了人员伤亡。

问题随之而来,当机器人杀手被赋予了生命判定的能力时,它们的行为边界在哪里?谁对它们的行为负责?如果出现错误或者滥用,后果由谁承担?这些疑问让人们对这项技术产生了担忧,毕竟,虽然它们是金属与电子的组合体,但它们的行为却直接影响着人类的生命权与安全。

在伦理层面,有人认为机器人杀手的使用是对人类尊严的侵犯,因为它削弱了士兵们的选择自由和道德责任,他们强调,无论科技如何进步,人类都应当保持在生死攸关的决策中扮演主导角色,另一些人则认为,机器人杀手能减少无谓的死亡,是科技进步带来的福祉,我们应该接受并适应这一变化。

法律层面上,国际法尚未明确规定机器人杀手的法律责任归属,这让许多人担心会出现灰色地带,导致无辜的受害者得不到公正,一些国家已经开始着手修改法律条文,试图涵盖这个新兴领域,但全球统一标准的制定仍是巨大的挑战。

技术进步总是伴随着争议,机器人杀手也不例外,尽管它们可能提高作战效率,降低人类士兵的直接风险,但其背后隐藏的伦理问题和法律难题不容忽视,我们不能简单地将机器人杀手视为一种单纯的技术工具,因为它们正日益成为影响战争形态、人性认知以及全球秩序的关键因素。

在未来,我们需要更多的跨学科对话,包括科学家、哲学家、法律专家和公众共同参与,以确保机器人杀手的发展既符合人类的伦理价值观,又满足我们的安全需求,这是一个需要深思熟虑的过程,而最终的答案,或许会重塑我们对于技术和生命的理解,让我们勇敢面对这个问题,而非回避它,因为我们既是科技进步的受益者,也是其责任的承担者。